Das Ende der Flitterwochenphase

Während wir in die zweite Hälfte des Jahres 2025 eintreten, sind die operativen Grenzen transformatorbasierter Systeme nicht mehr theoretisch. Sie werden direkt in Produktionsumgebungen angetroffen.

In Unternehmens-, Regierungs- und Sicherheitsumgebungen stoßen Führungskräfte auf dieselbe operative Realität: Systeme, die gebaut wurden, um in Demonstrationen zu beeindrucken, versagen unter der Last der Produktionsanforderungen. Halluzinierte Ausgaben, undurchsichtige Entscheidungspfade, ungoverned Autonomie und unkontrollierte Datenflüsse sind keine Forschungsprobleme mehr. Sie sind Audit-Befunde. Sie sind rechtliches Risiko. Sie sind Systemintegritätsfehler.

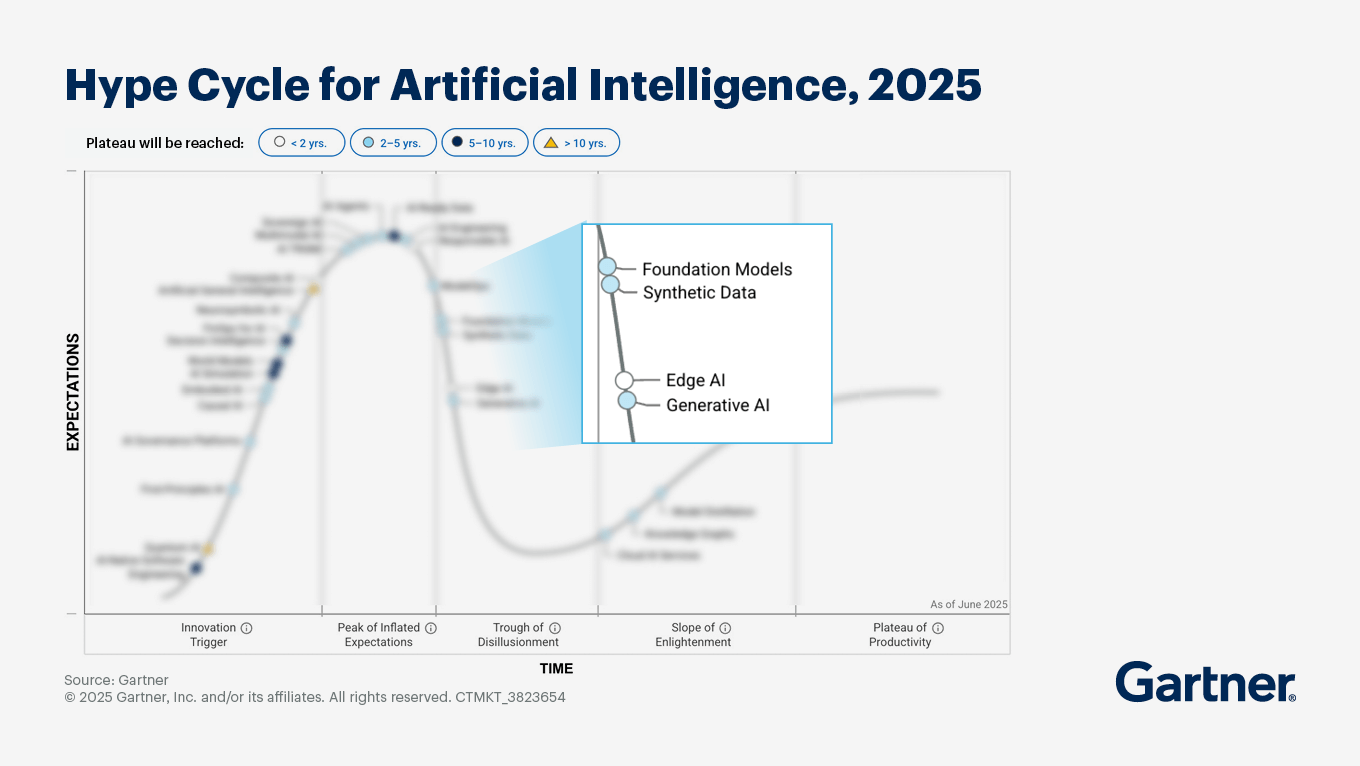

Der Markt tritt in das ein, was Gartner das „Tal der Enttäuschung“ nennt. Aber für Organisationen, die für nationale Sicherheit, kritische Infrastruktur oder regulierte Unternehmensoperationen verantwortlich sind, ist dies kein bloßes Hype-Zyklus-Ereignis. Es ist eine Systemabrechnung.

Wir sind nicht überrascht zu sehen, was passiert.

Das probabilistische Paradoxon

Der fundamentale Fehler in den meisten aktuellen KI-Strategien von Unternehmen ist die Erhebung probabilistischer Inferenz in Rollen, die deterministische Kontrolle erfordern.

Große neuronale Modelle sind mächtige Instrumente für die Wahrnehmung: Extraktion von Struktur aus Sprache, Telemetrie, Bildsprache und unstrukturierten Daten. Aber probabilistische Systeme operieren per Design auf Wahrscheinlichkeiten statt auf Garantien. Sie können von Natur aus nicht die strikte Durchsetzung von Einschränkungen, kausale Rückverfolgbarkeit und auditfähige Wiederholbarkeit bieten, die für Operationen mit hohen Konsequenzen erforderlich sind.

Der Versuch, ein globales Unternehmen, einen Verteidigungs-Workflow oder ein kritisches Infrastruktursystem direkt auf probabilistischen Ausgaben zu betreiben, ist wie der Bau eines Wolkenkratzers auf flüssigem Fundament. Es mag kurz stehen, aber es kann nicht von Dauer sein.

Hochsicherheitsumgebungen erfordern Systeme, die nicht nur beantworten können, was passiert ist, sondern:

- warum es passiert ist

- welche Regeln es gesteuert haben

- welche Daten es beeinflusst haben

- wer es autorisiert hat

- und wie es bei einer Überprüfung reproduziert werden kann

Dies ist kein Modellierungsproblem. Es ist ein Ingenieursproblem.

Engineering Determinismus: Der neurosymbolische Wandel

Teile der Industrie haben „Add-ons“ an LLM-Stacks angepasst, um ihre Mängel auszugleichen. Andere Teile schwenken auf das um, was im Großen und Ganzen als Neurosymbolische KI bezeichnet wird: Architekturen, die neuronale Systeme für die Wahrnehmung mit symbolischen Systemen für Logik, Durchsetzung von Einschränkungen und kausale Struktur kombinieren.

Bis 2026 werden diese Aspekte Teil der Basisanforderung für jedes KI-System sein, das in regulierten, sicherheitskritischen oder sicherheitssensiblen Bereichen operiert.

Bei Evodant ist diese Disziplin nicht nur eine Forschungsrichtung. Sie ist das Fundament unserer Symbiogent-Plattform.

Wir entwickeln Deterministische Entscheidungspipelines.

Hochsicherheit bedeutet Souveränität durch Design

Jenseits der Korrektheit liegt ein tieferes institutionelles Mandat: Souveränität.

In Umgebungen mit hohen Konsequenzen sind Daten keine Ware. Sie sind ein Vermögenswert, eine Verbindlichkeit und oft eine Rechtsfrage. Die Vorstellung, sensible Geheimdienstinformationen in undurchsichtige, extern verwaltete Modell-Ökosysteme zu exportieren, ist unvereinbar mit Unternehmensrisikomanagement, nationalen Sicherheitsrahmenwerken und langfristiger Systemobhut.

Wir architektieren Souveräne KI-Stacks: sicher, Zero-Trust und einsetzbar in vollständig kontrollierten institutionellen Umgebungen.

Diese Systeme sind konzipiert für:

- Air-Gapped- und klassifizierte Bereitstellungen

- regulierte Unternehmensoperationen

- langfristige Systemeigentümerschaft

- kontrollierte Modellobhut

- und kontinuierliche Governance unter interner Autorität

Wir bauen keine „besseren KI-Tools“. Wir entwickeln resiliente Entscheidungssysteme.

Die neue Frage

Die definierende Frage der Unternehmens-KI ist nicht mehr:

„Kann das System eine Antwort generieren?“

Sie lautet:

„Kann die Institution beweisen, warum das System gehandelt hat?“

Hochsicherheits-Engineering ist der Unterschied zwischen Automatisierung und Autorität.

Es ist die Grenze zwischen Neuheit und Systemen, denen man Konsequenzen anvertrauen kann.

Der Weg nach vorne

Wenn Sie für die Modernisierung von Systemen in Unternehmens-, Regierungs- oder Sicherheitsumgebungen verantwortlich sind und konfrontiert sind mit:

- den Grenzen der probabilistischen Automatisierung

- Governance- und Audit-Exposition

- unkontrollierter KI-Integration

- oder der Herausforderung, KI in regulierte Operationen zu bringen

dann ist der Weg nach vorne kein weiteres Modell.

Es ist Architektur.

Bei Evodant haben wir über zwanzig Jahre damit verbracht, groß angelegte, missionskritische Plattformen in Umgebungen zu architektieren und zu betreiben, in denen „meistens richtig“ synonym mit „gescheitert“ ist. In unseren Bereitstellungen haben wir Petabytes an Daten, Milliarden von Ereignissen und Billionen von Signalen in Produktionssystemen verarbeitet, die für Kontinuität, Rechenschaftspflicht und institutionelle Kontrolle gebaut wurden.

Wir engagieren uns für Institutionen durch Systemmodernisierung und Architekturberatung: Bewertung bestehender KI- und Datenplattformen, Auditierung von Angriffsflächen und Verbesserung der Sicherheit, Identifizierung von Hochsicherheits-Fehlermodi und Design deterministischer, souveräner Entscheidungsinfrastrukturen, die auf die operative Realität abgestimmt sind.

Wenn Ihre Organisation bereit ist, in Produktions-Grade-Intelligenz überzugehen, entwickeln wir die Fundamente, die erforderlich sind, um diesen Übergang zu unterstützen, oder setzen neue von Grund auf ein.