La Fin de la Lune de Miel

Alors que nous entrons dans la seconde moitié de 2025, les limites opérationnelles des systèmes basés sur les transformers ne sont plus théoriques. Elles sont rencontrées directement dans les environnements de production.

Dans les entreprises, les gouvernements et les environnements de sécurité, les dirigeants sont confrontés à la même réalité opérationnelle : les systèmes construits pour impressionner lors des démonstrations échouent sous le poids des exigences de production. Les sorties hallucinées, les chemins de décision opaques, l’autonomie non gouvernée et les flux de données incontrôlés ne sont plus des problèmes de recherche. Ce sont des constats d’audit. C’est une exposition juridique. Ce sont des échecs d’intégrité du système.

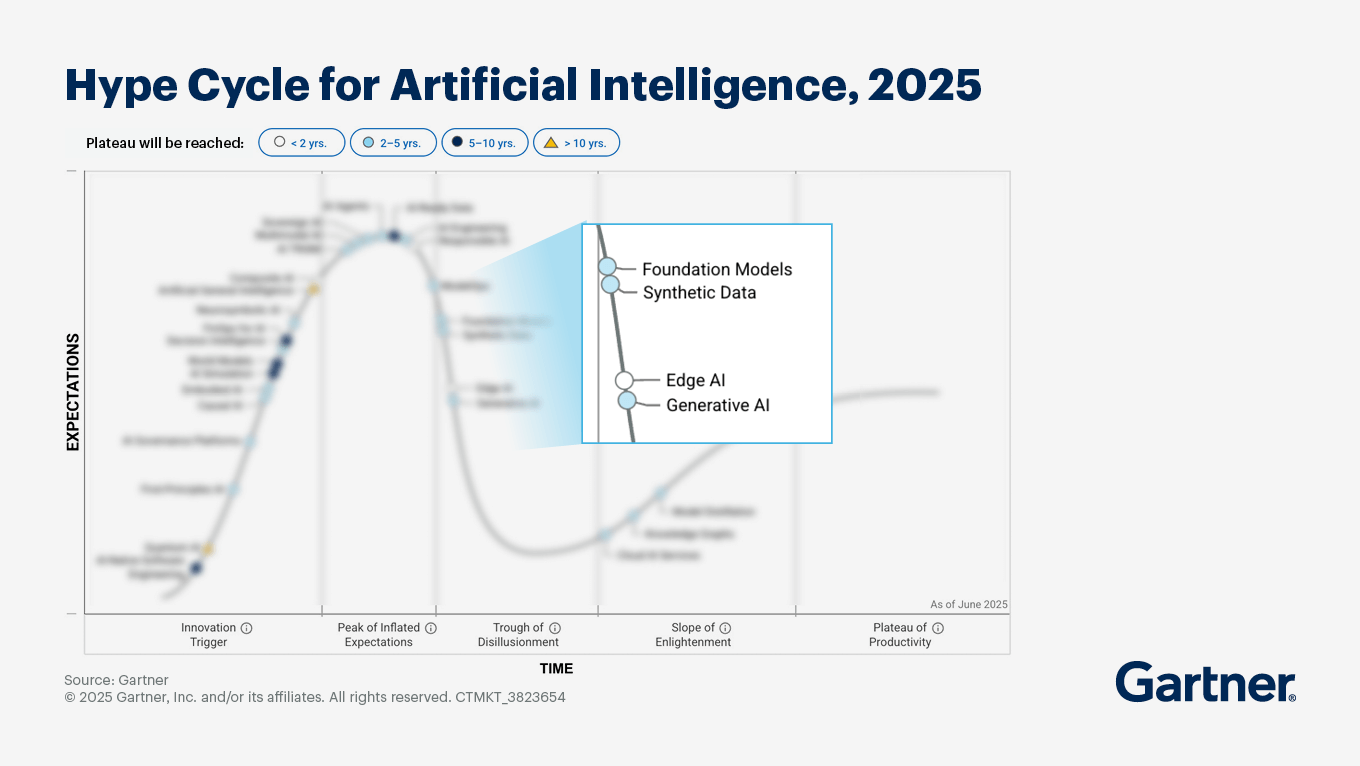

Le marché entre dans ce que Gartner appelle le « Gouffre de la Désillusion ». Mais pour les organisations responsables de la sécurité nationale, des infrastructures critiques ou des opérations d’entreprise réglementées, ce n’est pas juste un événement du cycle de la hype. C’est une remise en question des systèmes.

Nous ne sommes pas surpris de voir ce qui se passe.

Le Paradoxe Probabiliste

Le défaut fondamental de la plupart des stratégies actuelles d’IA en entreprise est l’élévation de l’inférence probabiliste à des rôles qui nécessitent un contrôle déterministe.

Les grands modèles neuronaux sont des instruments puissants pour la perception : extraire la structure du langage, de la télémétrie, de l’imagerie et des données non structurées. Mais les systèmes probabilistes, par conception, opèrent sur des vraisemblances plutôt que sur des garanties. Ils ne peuvent pas nativement fournir l’application rigide des contraintes, la traçabilité causale et la répétabilité de niveau audit requises pour les opérations à hautes conséquences.

Essayer de gérer une entreprise mondiale, un flux de travail de défense ou un système d’infrastructure critique directement sur des sorties probabilistes revient à construire un gratte-ciel sur des fondations liquides. Il peut tenir brièvement, mais il ne peut pas durer.

Les environnements de haute assurance exigent des systèmes capables de répondre non seulement à ce qui s’est passé, mais aussi :

- pourquoi c’est arrivé

- quelles règles l’ont régi

- quelles données l’ont influencé

- qui l’a autorisé

- et comment cela peut être reproduit sous examen

Ce n’est pas un problème de modélisation. C’est un problème d’ingénierie.

Ingénier le Déterminisme : Le Virage Neurosymbolique

Certaines parties de l’industrie ont adapté des « extensions » aux piles LLM pour compenser leurs déficiences. D’autres parties pivotent vers ce qui est largement appelé l’IA Neurosymbolique : des architectures qui combinent des systèmes neuronaux pour la perception avec des systèmes symboliques pour la logique, l’application des contraintes et la structure causale.

D’ici 2026, ces aspects feront partie des exigences de base pour tout système d’IA opérant dans des domaines réglementés, critiques pour la sécurité ou sensibles.

Chez Evodant, cette discipline n’est pas juste une direction de recherche. C’est la fondation de notre plateforme Symbiogent.

Nous ingénions des Pipelines de Décision Déterministes.

La Haute Assurance Signifie Souverain par Conception

Au-delà de l’exactitude se trouve un mandat institutionnel plus profond : la souveraineté.

Dans les environnements à hautes conséquences, les données ne sont pas une marchandise. C’est un actif, un passif et souvent une question de loi. La notion d’exporter des renseignements sensibles vers des écosystèmes de modèles opaques et gouvernés de l’extérieur est incompatible avec la gestion des risques d’entreprise, les cadres de sécurité nationale et la garde des systèmes à long terme.

Nous architecturons des piles d’IA Souveraines : sécurisées, zéro-confiance et déployables au sein d’environnements institutionnels entièrement contrôlés.

Ces systèmes sont conçus pour :

- les déploiements cloisonnés (air-gapped) et classifiés

- les opérations d’entreprise réglementées

- la propriété du système à long terme

- la garde contrôlée des modèles

- et une gouvernance continue sous autorité interne

Nous ne construisons pas de « meilleurs outils d’IA ». Nous ingénions des systèmes de décision résilients.

La Nouvelle Question

La question déterminante de l’IA d’entreprise n’est plus :

« Le système peut-il générer une réponse ? »

C’est :

« L’institution peut-elle prouver pourquoi le système a agi ? »

L’ingénierie de haute assurance est la différence entre l’automatisation et l’autorité.

C’est la ligne entre la nouveauté et les systèmes auxquels on peut confier des conséquences.

La Voie à Suivre

Si vous êtes responsable de la modernisation des systèmes dans des environnements d’entreprise, gouvernementaux ou de sécurité, et que vous êtes confronté à :

- les limites de l’automatisation probabiliste

- l’exposition à la gouvernance et à l’audit

- l’intégration incontrôlée de l’IA

- ou le défi d’amener l’IA dans des opérations réglementées

alors la voie à suivre n’est pas un autre modèle.

C’est l’architecture.

Chez Evodant, nous avons passé plus de vingt ans à architecturer et opérer des plateformes critiques à grande échelle dans des environnements où « à peu près juste » est synonyme d’« échec ». À travers nos déploiements, nous avons traité des pétaoctets de données, des milliards d’événements et des billions de signaux dans des systèmes de production construits pour la continuité, la responsabilité et le contrôle institutionnel.

Nous engageons les institutions à travers la modernisation des systèmes et le conseil en architecture : évaluant les plateformes d’IA et de données existantes, auditant les surfaces d’attaque et améliorant la sécurité, identifiant les modes de défaillance de haute assurance et concevant des infrastructures de décision déterministes et souveraines alignées sur la réalité opérationnelle.

Si votre organisation est prête à passer à une intelligence de niveau production, nous ingénions les fondations requises pour soutenir cette transition, ou en déployons de nouvelles à partir de zéro.